SUJETS SCIENTIFIQUES

SUJETS SCIENTIFIQUES

ou/et PHILOSOPHIQUES divers

ou/et

PHILOSOPHIQUES divers

SUJETS SCIENTIFIQUES

SUJETS SCIENTIFIQUES

| Liens et informations sur divers sujets scientifiques, technologiques ou philosophiques, en vrac mais par classement alphabétique et en évolution permanente ... (dernière mise à jour le 28/11/2024 avec chatGPT, érythropoièse , coelacanthe , hématopoièse , attoseconde , laniakea ). |

| ADN (acide désoxyribonucléique) L'ADN est une molécule très longue, présente dans toutes les cellules vivantes, qui est le support de l'information génétique héréditaire; elles est composée d'une succession de nucléotides (adénosine, cytidine, guanosine, thymidine) accrochés les uns aux autres dans un ordre très précis correspondant à l'information génétique. L'ADN est formé de deux brins complémentaires enroulés en une double hélice. |

| ALEXANDRITE L'alexandrite est une pierre, variété de chrysobéryl, très difficile à trouver (Tanzanie, Brésil, Sri Lanka, Madagascar, ...); elle se compose d'un oxyde de béryllium et d'aluminium et de petites quantités de chrome et de fer. Elle a été découverte en 1850, l'année du sacre du tsar Alexandre II de Russie, d'où son nom. On parle pour cette gemme de polychroïsme, car sa couleur se transforme selon la direction de l'éclairage qu'elle reçoit; verte lorsqu'elle est placée à la lumière du jour ou d'une lampe au mercure, elle devient rouge-violet à la lumière électrique; on nomme quelquefois cette propriété de changement de couleur l'effet alexandrite. Les alexandrites sont très largement utilisées dans l'industrie : lasers et autres instruments de haute technologie leur font une large place [notamment dans la composition des petites fenêtres de satellites qui doivent neutraliser certains rayons lumineux] ... |

| ALGORITHME

Le mot algorithme vient du nom du grand mathématicien AL KHWARIZMI (780-850) qui introduisit en Occident la numérotation

décimale importée d'Inde et les règles de calculs élémentaires correspondantes.

L'un des plus anciens est l' algorithme d'Euclide qui calcule le PGCD de deux entiers .

De manière générale, un algorithme est une suite finie d'opérations ou d'instructions

qui permettent de résoudre un problème. On utilise et on définit des algorithmes dans de nombreuses applications: fonctionnement des ordinateurs et pour tous les codes que l'on y construit, en cryptographie, dans le traitement de l'information, des images,

des textes, ...Historiquement les problèmes concernés étaient arithmétiques et on parlait d'algorithmes numériques, mais on définit aussi de

nombreux algorithmes non numériques dans de nombreuses autres situations: algorithmes de recherche Google ou Sayrac ou autres, algorithmes pour

les prévisions météo, pour diverses recherches en intelligence artificielle (voitures autonomes par exemple), algorithme Microsoft (ou autre)

pour la reconnaissance vocale (Siri, Cortana, Now, DeepFace...), reconnaisance faciale, vision par ordinateur, traitement automatisé du langage...Les techniques d'apprentissage profond (deep learning) constituent une classe

d'algorithmes d'apprentissage automatique. Naturellement l'algorithmique se développe particulièrement et naturellement

en mathématiques et en informatique. Mais dans de nombreuses autres démarches, dès que l'on développe une méthode, un processus systématique pour effectuer quelque chose (tri, classement,

recherche de mots, calculs, ...) et de manière générale dès que l'on veut optimiser l'exécution de procédés répétitifs, on sera amené à construire un algorithme. Dans le cadre de l'intelligence artificielle, on va devoir se préoccuper d'une certaine éthique des algorithmes, en particulier pour ceux qui concernent par exemple, la médecine, la chirurgie ou les traitements des données personnelles. |

| ANAMORPHOSE

L'anamorphose est un phénomène produit à l'aide de miroirs ou de lentilles (de diverses formes) et observé lorsque

ce système optique qui fournit l'image d'un objet amplifie différemment les dimensions verticale et horizontale de l'objet.

Il s'agit donc d'une déformation réversible d'une image à l'aide d'un certain système optique et qui crée ainsi une illusion

d'optique. Ce procédé est très ancien

puisque les peintres du XV ème siècle l'utilisaient déjà dans certaines de leurs oeuvres. On peut facilement décrire le processus physique de l'anamorphose ; l'anamorphose associée à une certaine surface S (représentant un miroir) pour un observateur représenté par un point O, est la transformation (symétrie de centre O) qui à tout point M (de l'objet) fait correspondre son symétrique M' par rapport au miroir (c'est-à-dire son symétrique par rapport au plan tangent au miroir en I point d'intersection de OM et du miroir). Suivant la nature de la surface on parlera d'anamorphose plane, sphérique, conique, cylindrique ... Trompe-l'oeil et anamorphose font tous deux appel au jeu des illusions comme dans le trompe-l'oeil architectural . Il existe bien sûr une infinité de méthodes pour déformer une image, l'anamorphose en est une brillament illustrée par, par exemple, Istvan Orosz ou M. C. Escher qui a illustré en particulier le ruban de Möbius , le cube impossible de L.A. Necker ou le triangle impossible de R. Penrose. |

| ANDROID Android est un système d'exploitation 'open source'(concerne les logiciels en libre distribution avec accès aux codes source) utilisant le noyau Linux, pour les smartphone, PDA et terminaux mobiles, conçu par Android, une startup rachetée en 2007 par Google. |

| ANTICYTHERE La machine (ou mécanisme) d'Anticythère est un mécanisme de bronze dont des fragments ont été trouvés en 1901 dans une épave de galère romaine près de l'île grecque Anticythère par des pêcheurs d’éponges. Cette galère aurait sombré il y a plus de 2000 ans (on parle de 87 avant J.-C.) dans les eaux grecques de la mer Egée au sud-est du Péloponèse, entre l'île de Cythère et la Crète. Bien que l'ensemble récupéré rassemble 82 fragments (rouages, cadrans et engrenages divers), il est largement incomplet et ne représente à peine qu'un tiers du mécanisme; il s'agit d'un calculateur astronomique utilisé pour prédire des éclipses, les phases de la Lune et la position des planètes connues à l'époque (mercure, vénus, mars, jupiter et saturne). On a reconstitué une réplique complète et fonctionnelle d'un tel mécanisme qui pourrait être le premier calculateur analogique construit par l'homme, et certainement la première horloge astronomique ... Il n'en reste pas moins que cette machine est une énigme , tant sur l'époque réelle de sa conception que sur l'état réel du mécanisme complet au temps de sa création. |

| ARN (acide ribonucléique)

L'ARN est une molécule présente chez pratiquement tous les êtres vivants. C'est un acide nucléique très proche chimiquement de

l' ADN avec quelques différences: il contient du ribose alors que le sucre de l'ADN est du désoxyribose et il est formé d'une hélice à simple brin au lieu de la double hélice de l'ADN. Il est chimiquement moins stable que l'ADN et il est issu de ce dernier par le mécanisme biologique appelé la transcription qui est assurée grâce à l'enzyme ARN polymérase qui réalise une copie d'un segment particulier de l'ADN. Les bases nucléiques de l'ARN sont l'adénine, la guanine, la cytosine et l'uracile (AGCU), celles de l'ADN étant AGCT. L' ARN messager (ARNm) est une copie transitoire d'un élément d'ADN et il est utilisé par les cellules pour la synthèse des protéines. Le vaccin de Pfizer contre la COVID-19 est une version récente des vaccins sans agent infectieux, les vaccins à ARN messager . |

|

ATTOSECONDE

Une attoseconde, c'est un milliardième de milliardième de seconde. La science attoseconde, abrégée en l’attoseconde (unité de durée correspondant à 10-18 seconde), est une science du comportement des molécules inventée par le professeur québécois André D. Bandrauk de l’université de Sherbrooke. Cette science est en quelque sorte une combinaison de chimie numérique, de physique quantique et de photonique moléculaire. Le prix Nobel de physique 2023 a été attribué aux Français Pierre Agostini et Anne L’Huillier, ainsi qu’à l’Autrichien Ferenc Krausz, pour leurs travaux portant sur des lasers ultrarapides permettant de créer des impulsions lumineuses exceptionnellement courtes, de l’ordre de l’attoseconde. On sait produire des impulsions de lumière attosecondes qui permettent de "voir" le mouvement des électrons ...D'autres applications des impulsions attosecondes sont en cours de développement ... Pour donner une idée de la petitesse de l'attoseconde, notons que l'âge de l'univers (13,8 milliards d'années) exprimée en secondes est de 1017 ! Mais la fraction de temps la plus courte mesurée est de 247 zeptosecondes, le temps que met un photon pour traverser une molécule de dihydrogène, la zeptoseconde valant 10-21 secondes ... |

AURORE POLAIRE (aurore boréale dans l'hémisphère nord et aurore australe

dans l'hémisphère sud ) Au XVII ° siècle, Galilée

(1564 - 1642) aurait été le premier

à utiliser l'expression 'aurore boréale' pour nommer ce phénomène. C'est

le soleil qui est responsable des aurores polaires par l'intermédiaire

des particules chargées (ions positifs, électrons et protons)

qu'il projette dans l'espace lors des violentes

tempêtes solaires. Ces particules 'solaires' chargées qui arrivent dans

la haute atmosphère terrestre (magnétosphère) excitent (ou ionisent) les

atomes

d'oxygène, d'azote, d'hydrogène de notre atmosphère, qui deviennent

alors subitement lumineux

(*) et

produisent les magnifiques voiles de lumière colorée

que sont les aurores polaires. On les nomme polaires parce qu'une fois

arrivées dans l'atmosphère terrestre, les particules sont prises au

piège

par le champ magnétique terrestre qui les oblige à se diriger vers les

pôles magnétiques nord (aurore boréale)

ou sud

(aurore

australe).

(*) Lorsqu'un atome est excité, un ou plusieurs de ses électrons changent de couche en libérant au passage un peu d'énergie et en émettant un photon (particule élémentaire de lumière visible). |

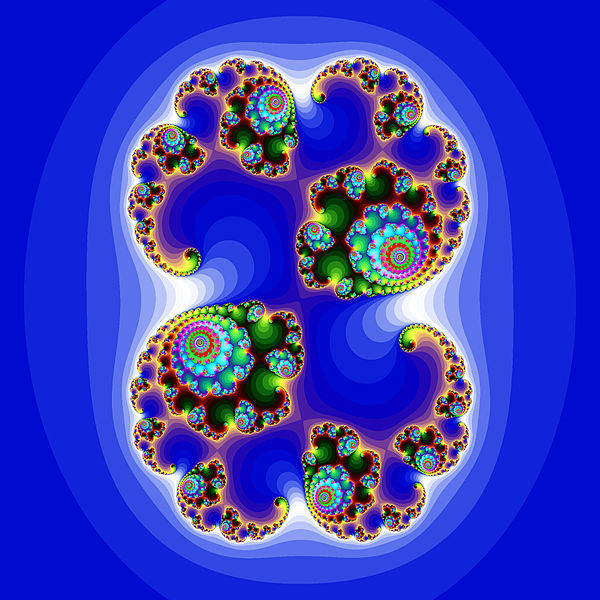

AUTOSIMILARITE

Autosimilarité

de trafics WEB et FTP

L'autosimilarité est la caractéristique d'un objet qui possède des similarités

lorsqu'on l'observe à différentes échelles. On peut encore dire qu'un objet

autosimilaire est un objet qui conserve sa forme, quelle que soit l'échelle à laquelle on l'observe. Les

objets autosimilaires sont encore appelés objets fractals ou fractales. Le

chou romanesco est un exemple d'objet autosimilaire naturel,

même s'il ne s'agit que d'une forme fractale 'approximative' comme de nombreux autres éléments naturels (nuages, arbres, fougères, flocons de neige, brocolis, vaisseaux sanguins, les côtes de Bretagne, ...); il y a en effet dans tous ces cas une structure autosimilaire qui se répète, mais à un nombre fini de niveaux. L'ensemble de Mandelbrot possède la propriété d'autosimilarité (parfaite) au voisinage de certains points, un ensemble de Julia est une parfaite fractale aussi; citons encore la courbe de Von Koch et le tapis de Sierpinski ... Voir les images d'une Galerie de fractales. |

| AXION

L'axion est une particule hypothétique qui serait le (ou un) constituant de la matière noire. Cet axion serait supposé stable, neutre (sans charge électrique), de très faible masse et de type boson; en outre il n'interagirait pas (ou très peu) avec la matière ordinaire. De nombreuses expériences sont en cours pour traquer les axions ... |

| AXOLOTL C'est un petit amphibien de 15 à 30 cm de longueur qui vit dans les lacs de montagne; il ne sort jamais de son milieu car il n'a pas de poumon. L'axolotl, animal strictement aquatique, passe sa vie à l'état larvaire sans jamais devenir adulte mais peut tout de même arriver à maturité sexuelle et se reproduire. La célébrité de cet animal vient du fait qu'il a la capacité de régénérer pratiquement tous ses organes défectueux, aussi bien un membre, un oeil que certaines parties de son cerveau. Sa tolérance aux greffes est également exceptionnelle et il est par ailleurs très résistant même au cancer. Cette espèce en risque de disparition intéresse beaucoup les biologistes et divers laboratoires en élèvent en captivité pour s'inspirer de leurs capacités et étudier leurs diverses particularités. L'axolotl est même devenu un animal répandu dans les animaleries qui les proposent aux aquariophiles (la variété albinos est considérée comme domestique, voir un très beau site sur l' élevage des axolotls ); on peut même dire qu'il a la tête d'un pokemon, en fait c'est lui qui a servi de modèle au personnage axolotl, un pokemon rare et ...réel! |

| BACTERIE C'est un micro-organisme vivant unicellulaire procaryote (c'est-à-dire sans noyau) dont le génome (patrimoine héréditaire d'un individu) est constitué d'ADN (acide désoxyribonucléique); la bactérie contient un seul chromosome (élément microscopique formé de molécules d'ADN) et éventuellement des plasmides (molécules d'ADN surnuméraires distinctes de l'ADN chromosomique). Certaines bactéries sont pathogènes et peuvent provoquer chez l'homme des infections bactériennes que l'on traite avec des antibiotiques (molécules qui détruisent ou bloquent la croissance de ces bactéries). Les symptômes d'une telle infection sont similaires à ceux observés lors d'une infection virale (due à un virus) pour laquelle les antibiotiques ne sont d'aucune utilité. On estime qu'il y a environ 1000 milliards de bactéries variées dans un corps humain ... |

| BASE DE DONNEES Une base de données (bdd) est un ensemble d'informations stockées dans un dispositif informatique; ces données sont organisées de manière à pouvoir en extraire diverses propriétés ou classifications. Les logiciels qui manipulent ainsi ces bdd sont la plupart du temps formulés dans un langage informatique de requête de type SQL. Les bdd sont utilisées dans un très grand nombre d'applications informatiques (gestion, décision, collecte de renseignements divers, moteurs de recherche,...) et sont extrêmement efficaces, tant par la rapidité de leur traitement que par les grandes quantités de données qu'elles peuvent contenir. |

| BATTERIE LITHIUM-ION (LI-ION). Les batteries (ou accumulateurs) lithium-ion (ou li-ion) occupent une place essentielle dans toute l'électronique portable, avec en particulier les tablettes et téléphones portables mais aussi les voitures électriques. C'est un type d' accumulateur lithium , dont la réaction électrochimique est basée sur l'élément lithium . Ces batteries sont puissantes, rechargeables, peuvent prendre des formes très réduites et variées et peuvent être déposées sur divers supports y compris flexibles; en outre elles ne nécessitent pratiquement pas de maintenance et sont très peu sensibles à l' effet mémoire (pas de problème si elles sont rechargées avant d'être complètement déchargées, ce qui n'est pas vrai pour les précédentes technologies à base de nickel). Les premières batteries li-ion ont été commercialisées en 1991 et le prix Nobel de chimie 2019 a été attribué aux trois inventeurs de cette découverte que l'on peut qualifier de révolutionnaire (et universelle): Stanley Whittingham , John B. Goodenough (qui avait 97 ans en 2019) et Akira Yoshino . |

| BATX B.A.T.X. pour Baidu, Alibaba, Tencent, Xiami, désigne les géants du Web chinois, l'équivalent du GAFA |

| Thomas BAYES (1701-1761) Thoms Bayes est un statisticien et philosophe anglais qui a formulé le théorème de Bayes , résultat célèbre en théorie des probabilités et statistiques qui a fourni, entre autres, une nouvelle inférence statistique (voir la différence entre l'inférence bayésienne et l'inférence fréquentiste ), l' inférence bayésienne ; il est ausssi à l'origine du bayésianisme un courant épistémologique qui utilise l'inférence bayésienne dans le raisonnement scientifique (voir le livre récent La formule du savoir de Lê Nguyên Hoang, 2018) pour proposer une philosophie unifiée du savoir fondée sur la formule de Bayes. Ce théorème est par ailleus largement utilisé en intelligence artificielle, en économie, psychologie et neurosciences. On peut même parler d'une révolution bayésienne dans les sciences cognitives qui proposent une nouvelle vision de notre insconscient: notre cerveau réaliserait en permanence des prédictions probabilistes sous la forme d'inférences inconscientes qui interfèrent avec nos processus conscients et les modifient plus ou moins pour nous permettre la meilleure analyse de notre environnement ... Construit et démontré à partir des notions de probabilités conditionnelles, la formule de Bayes est un théorème qui permet d'estimer la probabilité des causes à partir de l'observation et de la connaissance des conséquences. Pour la petite histoire signalons que ce résultat n'a été publié qu'en 1763 (par son ami Richard Price) et donc après la mort de Bayes. Etant donnés deux évènements A et B, la formule de Bayes nous dit que la probabilité de A sachant B est égale à la probabilité de B sachant A multipliée par la probabilité de A et divisée par celle de B: Parmi les multiples applications de cette formule, citons le principe du moinde choix au bridge décrit dans le livre d'Emile Borel. |

|

BENFORD. La loi de BENFORD : une étonnante loi dite encore loi des nombres anormaux. Elle concerne dans une quelconque liste de données numériques statistiques résultant d'une mesure (montants de chèques, nombre d'habitants de diverses villes, longueurs de fleuves ...), la répartition de ces données en terme de leur premier chiffre significatif (de 1 à 9); on constate par exemple que le chiffre 1 débute de telles données 6 fois plus souvent que le chiffre 9 !! On peut dire plus proprement que le premier chiffre significatif d'un nombre tiré de manière aléatoire suit une loi logarithmique (et non une loi uniforme comme on pourrait le penser!) et la fréquence d'apparition de ce premier chiffre est donnée sur le tableau suivant.

Frank Benford publie "The law of anomalous numbers" en 1938

dans Proceedings of the American Philosophical Society (78, p. 551), mais

en réalité c'est Simon Newcomb qui, en 1881, publia le premier cette

distribution dans American Journal of Mathematics (4, p. 39; après

observations de l'usure préférentielle des premières pages des tables de

logarithmes de l'époque !).

Ted Hill a démontré cette loi avec "The first digit phenomenon" en

1998 dans American Scientist (86, p. 358). |

| BIFURCATION La théorie des bifucations est détaillée dans le fichier Systèmes Dynamiques et Chaos . |

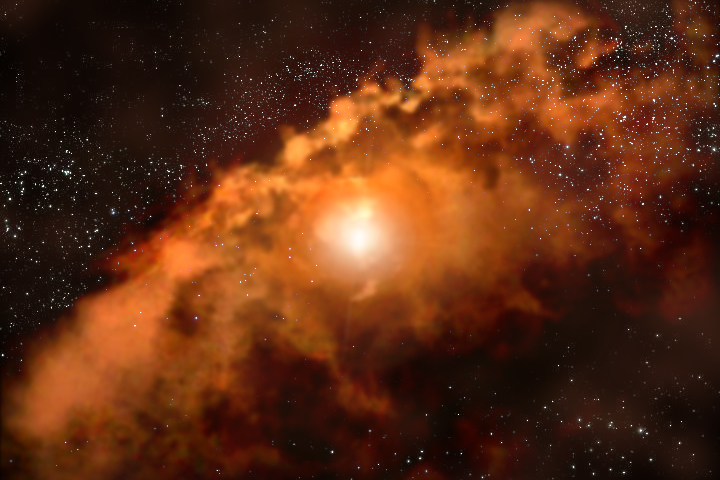

| BIG BANG Terme inventé dans les années 1950 par l'astrophysicien Fred Hoyle pour désigner par ironie le concept d'explosion originelle développé par Georges Lemaitre et Alexander Friedmann dans les années 1920 dans leur modèle cosmologique; le Big Bang est actuellement le nom d'un modèle cosmologique qui décrit l'origine et l'évolution de l'univers qui est adopté par une grande partie de la communauté scientifique. Cette théorie décrit la naissance de la matière (10-6 seconde après) il y a quelques 14 milliards d'années et son évolution jusqu'à nos jours .... |

| BIOPILE . Une biopile ou pile à bactéries ou encore pile microbienne, est une pile à combustible (processus qui convertit de l'énergie chimique de combustion de l'hydrogène en énergie électrique) dont la cathode est alimentée en oxygène et dont l'anode est placée dans un biofilm de bactéries, cette biomasse servant à la fois de combustible et de catalyseur. Uniquement alimentées par des subtances naturelles comme le sucre ( biopiles à glucose), des bactéries ou des plantes, les biopiles sont des piles à biocarburant qui se composent de trois éléments, une anode une cathode et un séparateur; il y a oxydation du combustible (glucose, bactéries ou micro-organismes) avec un comburant qui est le dioxygène; on peut parler de production verte d'électricité. Les biopiles seront-elles capables de remplacer un jour les piles classiques ? . |

| BITCOIN

De l'anglais bit, unité d'information et coin, pièce de monnaie, le

bitcoin de symbole BTC est une monnaie cryptographique

(ou crypto-monnaie ou monnaie virtuelle ou électronique ou ...), c'est-à-dire

un actif numérique pouvant être transféré (mais

non copié), entre deux utilisateurs sur internet sans autre intervenant ni autorité

centrale. C'est un système monétaire sans banque très fiable et sécurisé qui fonctionne pratiquement en temps réel. Tout le monde peut participer et créer un compte sans avoir à donner son identité. Cette monnaie virtuelle a été conçue par Satoshi Nakamato (pseudonyme d'un personnage toujours inconnu...); elle a été mise en fonctionnement en janvier 2009. Elle nécessite un réseau d'ordinateurs de type pair à pair (ou client-serveur, chaque client pouvant jouer aussi le rôle de serveur). Le système est limité à un nombre invariable de 21 millions de bitcoins. Ce réseau gère un registre de comptes, la blockchain, énorme base de données qui contient la totalité de l'historique des transactions. A côté du bitcoin il existe plus de 2000 autres cryptomonnaies (ethereum, litecoin, monero, estcoin, primecoin ...). Le minage est le mécanisme de création effective et de sécurisation des bitcoins. Pour cela les mineurs effectuent avec leur matériel informatique certains calculs mathématiques, des hashs cryptographiques (deux utilisations successives de la fonction SHA-256) sur un entête de bloc de la chaîne ... Bitcoin utilise une technologie pair à pair fonctionnant sans autorité centrale. La gestion des transactions et la création de bitcoins est prise en charge collectivement par le réseau. Bitcoin est libre et ouvert. Sa conception est publique, personne ne possède ni ne contrôle bitcoin et tous peuvent s'y joindre. Grâce à plusieurs de ses propriétés uniques, bitcoin conduit à des utilisations prometteuses qui ne pourraient pas être effectuées par les systèmes de paiement classiques, mais ...quid de son avenir?. |

| BLOB Le blob est formé d'une seule cellule géante (une des plus grandes au monde), ce n'est ni un animal, ni une plante, ni un champignon mais un peu des trois; c'est un myxomycète (mot à mot 'champignon gluant'), il fait partie de la famille des protistes (environ un millier d'espèces) et il vit dans les sous-bois depuis des centaines de millions d'années. Il est immortel, découpable et se régénère alors en quelques minutes et il a une forte croissance. Il n'a bien sûr pas de cervelle et pourtant des chercheurs ont réussi à lui apprendre des comportements qu'il peut transmettre à d'autres blobs ...Le blob est donc un organisme unicellulaire 'capable d'apprendre' sans cerveau . Des chercheurs ont pu vérifier que les blobs transmettent leur apprentissage en fusionnant avec leurs congénères . |

| BLOCKCHAIN

Une blockchain est une base de données décentralisée, infalsifiable qui fonctionne quasiment en temps réel

et qui ne peut avoir de panne ou bug, elle est de plus accessible à tous et constitue un registre de toutes les

transactions, inviolable et visible par tous. La blockchain intervient dans le développement de toutes les cryptomonnaies:

bitcoin, ethereum, ...,estcoin et primecoin entre autres (plus de 2000 cryptomonnaies). La blockchain est une chaîne de blocs de codes informatiques, chaque bloc contenant les attributs relatifs à une (ou plusieurs) transaction (expéditeur, destinataire, montant, date, heure) ainsi que certaines informations sur le bloc prédécesseur, tous ces éléments étant encryptés pour être sécurisés. C'est une technologie innovante bienvenue qui va révolutionner la finance. |

| BLU-RAY Le terme Blu-ray désigne le laser bleu utilisé pour ce nouveau format Haute Définition par opposition au laser rouge utilisé pour les DVD (ou les CD) classiques; avec la technologie blu-ray on a une plus grande précision, plus de données stockées (5 fois plus que sur un DVD classique) et plus de qualité qu'avec les CD/DVD standards. On obtient ainsi une image et un son en Haute Définiton. Ce format de disque numérique est breveté et commercialisé par le constructeur japonais SONY, il a été lançé en 2006. Les blu-ray pas forcément de meilleure qualité que les DVD classiques ? En principe les DVD classiques sont parfaitement lisibles sur les platines blu-ray, mais bien sûr on ne peut pas lire des disques blu-ray sur les anciens lecteurs de DVD .... |

| BLUETOOTH Il s'agit d'une technologie de réseau personnel sans fil (WPAN pour wireless personal area network) d'une faible portée (environ une dizaine de mètres, nettement moins qu'avec la technique Wi-Fi) permettant de relier des appareils (imprimante, téléphone, scanner, ordinateur, clavier, souris, ...) entre eux (sans liaison filaire donc !); elle utilise une technique radio courte distance dans une bande de fréquences comprise entre 2400 et 2483,5 MHz (dont l'exploitation ne nécessite pas de licence). |

| BOOLEEN Un booléen en logique et en programmation informatique est un type de variable à deux états (état VRAI ou TRUE ou 1, état FAUX ou FALSE ou 0); on utilisera assez souvent le bit (0 ou 1) pour représenter une telle variable. L'algèbre de Boole est la partie des mathématiques qui concerne les opérations et les fonctions sur ces variables dites encore variables logiques. La logique booléenne est utilisée dans pratiquement tous les langages de programmation. |

| Emile BOREL (1871-1956) Enfant prodige, passionné des mathématiques, Félix Édouard Justin Emile Borel (1871-1956), mathématicien aveyronnais (il est né à Saint-Affrique, ville dont il fut le maire de 1929 à 1941) a été curieux dans divers domaines et spécialiste essentiellement de la théorie des fonctions, des séries divergentes et du calcul des probabilités ... Il est l'auteur, en particulier en 1940, en collaboration avec le joueur d'échecs André Chéron (1880-1952), de la Théorie mathématique du bridge à la portée de tous ; il présente dans ce livre une méthode et un grand nombre de résultats numériques pour illustrer la théorie des probabalités au bridge. Sa femme, Marguerite Appell, était la fille du mathématicien Paul Appell ; romancière sous le pseudonyme de Camille Marbo elle obtint le prix Fémina en 1913 et fonda avec son mari, alors qu'il était président de la Société mathématique de France, la Revue du mois, journal scientifique et littéraire. Borel comprit très vite l'importance des probabilités qui pouvaient intervenir dans diverses disciplines (physique, chimie, astrophysique, biologie, économie,...), mais aussi dans le quotidien et dans divers jeux comme le bridge par exemple ...Il abandonna d'ailleurs en 1920 la chaire de théorie des fonctions à la Sorbonne pour occuper celle des probabilités et physique mathématique; on peut le considérer comme un des fondateurs de la version moderne de cette discipline mathématique dont il fit une branche de la théorie de la mesure. Il fût aussi à l'origine de la mise en place de l'Institut Statistique Universitaire de Paris en 1922 et de l'Institut Henri Poincaré (à vocation probabilités et physique mathématique) en 1928 dont il fût le premier directeur (et ce jusqu'en 1948). Depuis 2009 c'est Cédric Villani , mathématicien français (né à Brive-la-Gaillarde en 1973) médaille Fields 2010, qui occupe le poste de directeur de l'I.H.P.. Emile Borel a même assez largement participé à la création en 1939 du Centre National de la Recherche Scientifique (CNRS), le plus grand organisme public français de recherche scientifique (dont le président depuis 2010 est le chimiste Alain Fuchs). Dans l'un de ses livres sur les probabilités, il formule en 1909 sa célèbre expérience de pensée (méthode initiée par Galilée qui en faisait la clé de ses recherches scientifiques) sur le paradoxe du singe savant (ou théorème du singe infini): un singe qui tape indéfiniment sur un clavier (d'ordinateur de nos jours mais d'une machine à écrire à l'époque!) de manière aléatoire pourra 'presque sûrement' écrire un texte donné fini (comme Hamlet, la Bible ou l'annuaire téléphonique de l'Aveyron): la probabilité correspondante est bien sûr extrêmement faible (même si l'on considère que le singe tape pendant une durée de l'ordre de l'âge de l'univers) mais elle n'est 'pas nulle'! (les probabilistes préfèrent dire presque sûrement vrai plutôt que presque partout vrai au sens de la mesure de Lebesgue , c'est-à-dire vrai sauf sur un ensemble dit négligeable, c'est-à-dire de mesure nulle au sens de Lebesgue - mathématicien dont Borel fût le directeur de thèse -) D'après Borel, "la théorie des probabilités constitue un outil mathématique indispensable pour une forme d’accès intuitif au réel (y compris le réel mathématique) en fournissant sur lui des renseignements de type statistique sur lequel fonder le raisonnement et l’action". On peut consulter les travaux essentiels de Borel dans la bibliothèque bibm@th.net . |

| BOSON

DE HIGGS Les particules élémentaires de la physique se classent

en deux catégories: les fermions ou particules de matière [quarks et

leptons (électron, neutrinos, muon et tau)] et les bosons (de jauge) qui

sont les supports des quatre forces fondamentales, l'électromagnétisme,

les intéractions forte et faible et la gravitation (respectivement photons, gluons,

bosons W+, W- et Z, et peut-être l'hypothétique graviton). Les fermions

possèdent un spin

demi entier et les bosons un spin entier; le spin

est une propriété quantique intrinsèque de chaque particule, au

même tire que sa charge électrique ou sa masse. Notons bien que les nucléons

(protons et neutrons)

ne sont pas des particules élémentaires mais sont constitués de

3 quarks en interaction. Le boson de Higgs, qui est une particule

hypothétique non encore découverte expérimentalement (en 2010), est de spin 0;

cette particule a été prédite en 1964 par Peter

Higgs pour expliquer pourquoi certaines particules sont dotées d'une

masse et d'autres pas. Le plus grand accelérateur de particules du monde

(LHC, ou

grand collisionneur de hadrons, de Genève) traque

les particules insaisissables ou rares et en particulier le boson de

Higgs, pièce manquante de la théorie 'standard' des particules

élémentaires (voir Le

boson manquant associé au champ de Higgs ). Mise à jour 04/07/2012: découverte effective du boson de Higgs ! |

| BRACHISTOCHRONE

La détermination analytique des mouvements pose souvent un problème particulier d'extrémum: la recherche de la valeur

stationnaire (ou extrémum local relatif) d'une intégrale définie. La branche des mathématiques qui concerne de tels

sujets est le calcul des variations (on parle encore de problèmes variationnels). Un problème typique et historique de telle sorte est celui de la BRACHISTOCHRONE (ou courbe de plus rapide descente, du grec brakhistos qui signifie 'le plus court') formulé pour la première fois et résolu (probablement en 1696) par le mathématicien et physicien suisse Jean 1er BERNOULLI (1657-1748), frère de Jacques 1er (1654-1705) et l'un des 7 membres de la famille Bernoulli qui s'est largement illustrée dans les mathématiques et la physique au cours des XVII et XVIII ème siècles. Il s'agit de trouver dans un plan vertical la courbe joignant deux points A et B, non situés sur une même verticale, le long de laquelle un point matériel soumis à la seule gravitation terrestre mettra le MINIMUM de temps pour aller de A à B. En 1696, le calcul des variations n'étant pas encore connu, Jean Bernoulli a résolu le problème de très belle manière en se servant du principe de Fermat en optique et a assez facilement obtenu l'équation différentielle de la courbe solution qui est l'opposée d'un arc de cycloïde à tangente verticale à l'origine, et non un arc de cercle comme le pensait Galilée en 1633. Décrivons la démarche en utilisant le calcul des variations , qui a d'ailleurs trouvé ses origines dans ce travail de Jean Bernoulli, mais qui ne s'est parfaitement installé qu'en 1744 avec Leonhard Euler (1707-1783) et précisé en 1760 avec Joseph-Louis Lagrange (1736-1813). Choisissons un système d'axes Ox,Oy où Oy est la verticale descendante, A (a, 0) , B (b, β), et notons y = f(x) l'équation de la courbe cherchée. Appelons s l'abcisse curviligne sur cette courbe et v = ds/dt la vitesse du point et rappelons que ds2 = dx2 + dy2 = (1 + y'2) dx2. Il nous faut donc minimiser l'intégrale définie On montre que la courbe solution de ce problème variationnel est bien l'opposée d'un arc de cycloïde droite à tangente verticale à l'origine. On rappelle que la cycloïde droite (ou roue d'Aristote ou roulette de Pascal) est une courbe plane engendrée par la trajectoire d'un point fixé à un cercle de rayon R qui roule sans glisser sur une droite; par ailleurs la demi-arche de cycloïde est tautochrone (tout point matériel lâché avec une vitesse initiale nulle en un point quelconque de l'arche, sauf au point B le plus bas, met le même temps pour atteindre B, T = π√R/g) et aussi isochrone (tout point matériel se déplaçant sans frottement sur la courbe sous la seule action de la pesanteur a un mouvemnent périodique indépendant de la postion initiale, de période T = 4π√R/g). La formulation générale d'un tel problème variationnel concerne une intégrale définie de la forme la fonction inconnue y prenant des valeurs données en a et b, f(a) = α, f(b) = β . On démontre que la condition nécessaire et suffisante de stationnarité (ou extrémum local relatif ) de l'intégrale I est qu'elle vérifie l'équation d'Euler-Lagrange suivante: Les équations d'Euler-Lagrange jouent un rôle fondamental dans le calcul des variations et dans la mécanique analytique et en particulier dans de nombreux problèmes de géodésiques. |

| CAPTCHA Le terme captcha est un acronyme (Completely Automated Public Turing test to tell Computers and Humans Apart) qui désigne une marque commerciale et qui correspond à une famille de tests de type Turing permettant de différencier automatiquement un utilisateur humain d'un ordinateur ou robot aspirateur de données. Concrètement il s'agit d'un code à insérer sur internet pour vérifier que ce n'est pas un robot (un autre code plus ou moins néfaste ou pirate) qui tente d'utiliser un lien en répondant à un formulaire ou en envoyant un message à une adresse mail. Le Test de Turing a été publié en 1950 par son auteur Alan Turing. Le captcha le plus courant est un test visuel basé sur l'identification des diverses lettres (plus ou moins torturées) dans un texte ou une image. On peut aussi proposer un nombre aléatoire dont on devra déduire divers éléments (2 premiers, 3 derniers chiffres ...). |

| CARTE à PUCE La carte à puce est une invention française, brevetée par Roland Moreno en 1974. L'innovation consiste à loger dans l'épaisseur d'une carte, la "puce" d'un circuit intégré et un connecteur extra-plat permettant de le raccorder facilement à des circuits extérieurs. La carte à puce est de nos jours omniprésente dans tous les secteurs d'activité: cartes bancaires, télécartes diverses, cartes Vitale, cartes commerciales variées, cartes pour décodeurs de télévision, cartes de téléphones, .... C'est un produit très répandu, assez simple et plutôt sûr (voir la sécurité logicielle des cartes à puce). |

| CASSITERITE La cassitérite est le minerai le plus important produit à partir de l'étain, sa formule chimique est Sn O2 et il a une longévité élevée; son exploitation se fait en particulier au Congo et en Bolivie. Il est beaucoup utilisé en électronique où il est pratiquement indispensable dans tous les circuits imprimés de nos divers appareils électroniques (téléphones mobiles entre autres ). |

| CATEGORIE (théorie des catégories) La théorie des catégories a été fondée dans les années 1940 par S. Eilenberg et S. Mac Lane; une catégorie est une collection bien définie d'objets de même nature et de transformations entre eux (flèches ou morphismes), munie d'une loi de composition. Une catégorie est encore un graphe orienté dont la composition des flèches a la propriété d'associativité. On peut, par exemple, parfaitement définir la catégorie des ensembles alors que l'on sait que la notion d'ensemble de tous les ensembles est contradictoire ( paradoxe de Russell ou paradoxe du barbier ). Si l'on dispose de deux catégories, on peut quelquefois définir une correspondance, que l'on appelle un foncteur (ou foncteur covariant) entre les deux, qui associe les morphismes de l'une à ceux de l'autre. On peut alors définir des catégories de catégories. Accueillie avec scepticisme à ses débuts, cette théorie est vite devenue utile et inconstestable, en particulier grâce à son adaptation à une grande variété de disciplines (algèbre, géométrie, topologie ...mais aussi en physique, en biologie ou en linguistique). Il faut citer les apports décisifs de A. Grothendieck en particulier en topologie algébrique. Les catégories concernent de nombreux et divers objets mathématiques et c'est l'abstraction qui en a facilité la compréhension; en ce sens la notion d'infini-catégorie (analogue en dimension infinie d'une catégorie) a permis de construire de nouvelles connexions entre des concepts de plus en plus complexes et abstraits et des objets de plus en plus différents et éloignés, mais qui pourtant ont des comportements 'analogues' (deux objets isomorphes seront considérés comme 'identiques'). On arrive ainsi à établir des théorèmes s'appliquant simultanément à une grande diversité d'objets mathématiques, sans avoir à spécifier exactement de quels types d'objets il s'agit ! Sans cela ces théorèmes auraient été impossibles à démontrer rigoureusement et même à énoncer (voir E. Riehl et D. Verity ). Phases topologiques, états exotiques de la matière en physique ( Nobel de physique 2016 ), langage Haskell en informatique, action des enzymes dans des réseaux métaboliques, détection de similarités grammaticales entre langues différentes, ...toutes ces avancées sont issues de plus ou moins près de la théorie des catégories. |

| ChatGPT

ChatGPT, abréviation de Chat Generative Pre-trained Transformer, est un agent conversationnel (de type chatbot) qui utilise l' intelligence artificielle générative qui est un type d' IA . ChatGPT est un modèle de langage développé par OpenAI; conçu pour comprendre et générer du texte en langage naturel, il peut répondre à des questions, fournir des informations, rédiger des textes et engager des conversations sur divers sujets. Grâce à son apprentissage à partir d'un large éventail de données, ChatGPT est capable de simuler un dialogue humain, bien qu'il n'ait pas de conscience (ni de ce qu'il est ni de ce qu'il fait) ni d'opinions propres. Son utilisation est variée, allant de l'assistance à la rédaction à l'éducation et au divertissement. 1. Fonctionnalités: Génération de texte: ChatGPT peut créer des phrases, des paragraphes et même des articles complets sur une grande variété de sujets. Questions-Réponses: il peut répondre à des questions en fournissant des informations précises et pertinentes. Assistance conversationnelle: il peut mener des discussions, fournir des conseils, et même assister dans des tâches créatives comme l'écriture de scénarios ou de poèmes. 2. Applications: Service client: utilisé par des entreprises pour automatiser les réponses aux questions fréquentes des clients. Éducation: outil d'aide aux étudiants pour expliquer des concepts ou résoudre des problèmes. Création de contenu: employé pour rédiger des articles, des blogs, des discours, etc. Développement personnel: utilisé pour donner des conseils sur des sujets variés tels que la santé mentale ou la productivité. 3. Modèle: Architecture Transformer: ChatGPT utilise une architecture qui se base sur des mécanismes d'attention, permettant de traiter le texte de manière plus efficace, en tenant compte du contexte. Pré-entraînement et Affinage: le modèle est pré-entraîné sur une vaste quantité de données textuelles pour comprendre la langue, puis affiné avec des techniques d'entraînement supervisé. 4. Limitations: Compréhension du contexte: parfois, ChatGPT peut mal interpréter des demandes complexes ou ambigües. Données mises à jour: il peut ne pas avoir accès aux informations les plus récentes au-delà de sa date de formation, ce qui limite sa capacité à traiter des événements récents ou des tendances émergentes. Biais: comme tout modèle d'IA, ChatGPT peut refléter des biais présents dans les données sur lesquelles il a été entraîné. 5. Versions et évolutions: OpenAI a régulièrement mis à jour ChatGPT, améliorant ses performances et ses fonctionnalités. Les versions les plus récentes visent à améliorer la précision, la sécurité et l'expérience utilisateur en général. 6. Considérations éthiques: OpenAI attache une grande importance à l’utilisation éthique de son intelligence artificielle, en cherchant à minimiser les risques d’abus et à assurer que les utilisateurs comprennent les capacités et les limites du modèle. En résumé, ChatGPT est une avancée significative dans le domaine de l' IA , offrant des outils puissants pour la communication et l'assistance dans de nombreux domaines, tout en posant des défis et des considérations éthiques à prendre. L'application mobile ChatGPT à accès gratuit, lançée en 2023, intègre une technologie de reconnaissance vocale, Whisper, qui permet de converser par la voix avec le robot. |

| CHAOS et SYSTEMES DYNAMIQUES La théorie du chaos est une théorie mathématique et physique concernant l'étude des systèmes dynamiques (ou systèmes évolutifs). Le père fondateur de la théorie du chaos (en tant que nouvelle réelle branche récente des mathématiques) est René THOM (1923 - 2002); il a obtenu, pour ses divers travaux en topologie différentielle, la médaille Fields en 1958 et il a publié en 1972 l'article de base de la théorie des catastrophes (voir son célèbre livre sur le sujet 'Stabilité structurelle et morphogenèse' qui développe la théorie en termes tout à fait abordables par un large public). Pour l'origine (plus ancienne) de la théorie physique (et mécanique) des systèmes dynamiques, il faut naturellement citer le problème des 3 corps traité en 1889 par le grand mathématicien (et physicien, et philosophe) français Henri Poincaré (1854 - 1912). |

| CHIRALITE La chiralité est la propriété d'un corps ou d'un système de ne pas être superposable à son image dans un miroir (c'est-à-dire à son image dans une symétrie par rapport à un plan); un tel corps ne possède donc pas de plan de symétrie. Un objet ayant cette propriété sera dit chiral (du grec signifiant la main, celle-ci étant l'objet chiral le plus familier); cet objet et son image sont deux énantiomères. Ces deux formes, dites énantiomorphes, sont appelées lévogyre et dextrogyre. Un objet superposable à son image miroir est dit achiral; il possède donc un axe, un plan ou un centre de symétrie. En mathématiques, un polyèdre sera dit chiral s'il n'est pas superposable à son image par réflexion; un solide platonicien n'est pas chiral, un noeud peut être chiral (noeud de trèfle par exemple) ou pas (noeud trivial ou noeud de huit). Ainsi les organismes vivants n'utilisent (pourquoi?) que la forme lévogyre des acides aminés et que la forme dextrogyre pour les sucres ...on parle du mystère de la chiralité du vivant . |

| CHONDRITE En astronomie et plus particulièrment en planétologie, une chondrite est un type de météorite composée de chondres qui sont des petites sphérules pierreuses. Ces petits corps célestes de type astéroïdes primitifs sont formées essentiellement de silicates (olivine, hypersthène ou plagioclases) et de quelques rares éléments métalliques; on les nomme encore météorites indifférenciées et ce sont les plus abondantes trouvées sur Terre (elles représentent environ 80 à 90 % des météorites récupérées). Les chondrites ont une composition chimique globale proche de celle de la Terre et peuvent donc nous renseigner sur la composition chimique de notre planète et en particulier du noyau terrestre. Considérées comme les plus primitives du système solaire, les chondrites carbonées (dites encore de type C) sont riches en carbonne (en eau et en gaz rares) et peuvent contenir des éléments organiques , en particulier des acides aminés . En médecine, une chondrite est une inflammation d'un cartilage, comme la polychondrite ou l'ostéochondrite. |

| CHROMOSOME . Les chromosomes sont des structures microscopiques, constituées d'ADN et de protéines, localisées dans le noyau des cellules du corps. Ils sont porteurs des gènes (25.000 environ) qui caractérisent l'information génétique de chaque individu. Chaque chromosome a une forme caractéristique. Dans les cellules eucaryotes, les chromosomes se trouvent dans le noyau; dans les cellules procaryotes, qui ne contiennent qu'un seul chromosome circulaire, ce dernier se trouve dans la région du cytoplasme appelée nucléoïde. Le caryotype humain normal comporte 46 chromosomes qui sont constitués par 23 paires, 22 paires de chromosomes identiques chez tous les humains (appelés autosomes) et une paire de chromosomes sexuels ou gonosomes. La femme possède une paire de chromosomes X, cependant que l'homme possède un X et un Y. Chez les animaux, le nombre de chromosomes varie de 2 pour une fourmi australienne à 440 pour un papillon marocain, le record absolu étant détenu par une fougère avec 1440 ! |

| CIGALES

PERIODIQUES Les cigales de nos régions européennes ont une vie très brève de

2 à 3 semaines et leurs larves ont un cycle sous-terrain de 2 à 5 ans. Dans les forêts de l'est de l'Amérique du Nord, il existe trois espèces de

cigales périodiques de même brève vie mais dont la durée du cycle est de 17 ans: les cigales 'magicicada septendecim'. D'autres espèces de cigales périodiques

ont un cycle de 13 ou 7 ans, toujours un nombre premier... Pendant 17 ans les larves de ces cigales périodiques restent enfouies sous la terre en survivant en suçant la sève des racines des arbres. Au mois de mai de leur 17 ème année elles sortent toutes en masse à l'air libre, de manière synchronisée pour les trois espèces, et envahissent la forêt sur presque deux millions d'hectares. Elles vont alors s'accoupler et se reproduire. En juillet elles vont mourir et leurs nombreuses larves sorties des oeufs (environ 800 oeufs par femelle) vont tomber des arbres et s'enfouir dans le sol et le cycle des 17 ans va reprendre. Depuis plus d'un siècle, tous les 17 ans on a noté ce phénomène dans la moitié orientale des Etats-Unis. En 2013, ce sont 100 milliards de telles cigales qui ont été recensées dans la région de New-York! Pourquoi y-a-t-il des cigales de cycles 17, 13 ou 7 et pas 10, 12 ou 14? Les nombres 7, 13 et 17 sont d'une part premiers (et donc non divisibles par un entier, autre que 1, plus petit qu'eux-mêmes) et en outre supérieurs au cycle de 2 à 5 ans des prédateurs éventuels et conformément à la théorie de Darwin , ce mode de reproduction est une arme pour la survie de ces cigales, un cycle de 17 ou 13 ans ne pouvant être intercepté efficacement par des prédateurs à durée de vie inférieure (et non diviseur de 13 ou 17: par exemple un prédateur avec un cycle de 5 ans ne pourra dévorer des cigales que tous les 17 x 5 = 85 ans!). |

| CLE USB C'est un petit support de stockage de données numériques amovible qui se branche sur un port USB (Universal Serial Bus) d'un ordinateur, d'une chaîne Hi-Fi, d'une platine DVD, d'un téléviseur, ...La clé USB possède une mémoire flash et possède maintenant des capacités de plusieurs Go. Sa très petite taille en fait un outil très pratique et très courant pour des transports de données. |

| CLOUD COMPUTING Le cloud computing est un concept de déportation de ressources sur des serveurs distants contrairement à l'hébergement traditionnel sur la propre machine de l'utilisateur. Déjà lançé par les services de stockage à distance et pour les calculs ou logiciels en ligne (calculs scientifiques et serveurs distants liés en réseau), cette technique pourrait largement s'étendre: Le clound computing, l'informatique de demain? |

| CODE-BARRE

Imaginé en 1952 par deux étudiants américains, un code-barre représente une donnée numérique ou alphanumérique sous la

forme d'un symbole formé de barres et d'espaces verticaux parallèles d'épaisseurs variables en fonction des éléments à décrire.

C'est un lecteur de code-barre, de type capteur électronique, qui permet de le décrypter. Plus récemment, un QRcode a été créé par Masahiro Hara en 1999 et depuis les années 2000, il est l'un des codes les plus populaires; il permet en particulier d'être décodé rapidement (d'où son nom Quick Reponse Code) et peut stocker beaucoup plus d'informations que le code-barre classique. Ce QRCODE est un type de code-barre qui peut être lu par un smartphone ou une webcam et dont l'utilisation est de plus en plus répandue, en particulier pour récupérer un lien vers tel ou tel site, puisqu'il peut contenir aussi bien du texte, des SMS ou des adresses Web ...De nombreuses applications pour smartphones permettent de scanner mais aussi de créer des QRcodes et le paiement par QRcode devient de plus en plus courant. |

|

COELACANTHE

Poisson actinistien, apparu au Dévonien, connu en tant que fossile avant d’être découvert vivant par l’ornithologue sud-africaine Marjorie Courtenay-Latimer en 1938 (genre Latimeria pour les spécimens actuels). Les cœlacanthes vivent entre 100 et 400 mètres de profondeur, sur les marges ouest et est de l'océan Indien. Mais ses populations sont très réduites. Confrontée aux actions anthropiques, l'espèce est aujourd'hui en grand danger d'extinction. Souvent décrit comme un fossile vivant, le cœlacanthe appartient à un groupe de poissons qui étaient largement répandus il y a plus de 350 millions d'années, bien avant l'apparition des dinosaures. Évoluant jusqu’à 700 m de profondeur, il se déplace lentement à l'aide de ses nageoires lobées qui bougent de manière alternée, comme un quadrupède. Le Cœlacanthe un poisson énigmatique |

|

COMPRESSION d'IMAGES (fondements historiques et mathématiques des méthodes de compression d'images; précis et assez complet, avec des références). La compression d'image est une application de la compression de données pour des images numériques; en réduisant la taille des images, on pourra en emmagasiner un peu plus dans un espace donné ou les transmettre plus rapidement. On peut faire, en particulier, de la compression d'images par ondlettes (voir la rubrique ondelettes). |

|

CONJECTURE

Une conjecture , en mathématiques, est une assertion (une règle ou une affirmation) qui exprime

une propriété qui se trouve toujours vérifiée (aucun contre-exemple ne vient l'infirmer), mais qui n'a jamais

(ou pas encore) été démontrée. |

|

CORONAVIRUS

Découverts pour la première fois dans les années 1960, sous la forme du virus de la bronchite infectieuse du poulet,

les coronavirus constituent un groupe de virus enveloppés qui produisent diverses pathologies

chez les mammifères et les oiseaux, des infections des voies respiratoires chez l'homme. |

| COURRIEL (ou courrier électronique, e-mail, email ou mail) C'est un service de transmission de messages envoyés électroniquement via un réseau informatique (essentiellement internet) dans la boîte aux lettres électronique d'un destinataire choisi par l'émetteur. Les premiers mails ont été envoyés en 1969. En ce début de 2012, on estime que plus de 3 millions de mails sont envoyés dans le monde par seconde! Malheureusement plus de 3/4 de ces messages sont des spams ... |

| CRISPR-Cas9 CRISPR-Cas9 est une endonucléase (enzyme spécialisée pour couper l'ADN) qui peut être utilisée en génie génétique pour modifier le génome des cellules animales ou végétales. On a découvert récemment que les bactéries mettent en place des stratégies très efficaces qui dépendent d'ARN, nommées les CRISPR, pour se protéger des bactériophages; elles mettent ainsi en place une espèce d'immunité, en se 'souvenant' de l'assaillant. Ce processus immunitaire des bactéries est à la base de la technologie CRISPR-Cas9, qui permet de modifier facilement et rapidement les génomes. Cet outil révolutionnaire du génie génétique est largement utilisé et développé dans de très nombreux laboratoires et cette méthode a été nommée la découverte capitale de l'année 2015 en génétique. |

| CRISTAL TEMPOREL

Un cristal temporel est une structure atomique théorique qui est périodique dans l'espace (comme un banal cristal) mais aussi dans le temps; on définit ainsi un cristal dans 4 dimensions. Cette

structure a été proposée en 2012 par le physicien américain Frank Wilczek, colauréat du prix Nobel 2004 de physique pour ses travaux sur l'interaction forte. Si les cristaux ordinaires se caractérisent par une brisure spontanée de symétrie spatiale, les cristaux temporels mettent en jeu une brisure spontanée de la symétrie temporelle. Fin 2016 et début 2017 les premiers cristaux temporels discrets ont été créés à partir de 10 ions d'ytterbium (les atomes d'ytterbium permettent aussi de construire des horloges atomiques dix milliards de fois plus précises que les montres à quartz). L'oscillation dans le temps d'un cristal temporel s'effectue à énergie constante; on est en présence d'une nouvelle sorte de matière hors d'équilibre. Un système d'atomes peut donc osciller entre deux formes sans avoir besoin pour cela d'apport d'une quelconque énergie; cette périodicité temporelle représente l'état d'énergie minimal du système (soit son état de repos). C'est donc un exploit purement expérimental, réalisé indépendamment par plusieurs équipes, qui concrétise le concept théorique imaginé en 2012. Ce nouveau type de cristal atomique qui peut vibrer naturellement avec une périodicité bien précise à énergie constante, pourrait constituer une future mémoire ou horloge plus précise pour les futurs ordinateurs quantiques , et peut-être aussi nous conduire à une meilleure compréhension de la cosmologie et en particulier des trous noirs ... |

| CRYPTOGRAPHIE (revue quasi exhaustive des procédés de cryptographie et de leurs applications dans le lien précédent) La cryptographie est la partie de la cryptologie (la science du secret) qui réalise, pour assurer la confidentialité des transferts de données, des messages codés (ou chiffrés) à l'aide de clés, cependant que la cryptanalyse est chargée de déchiffrer ces messages cryptés. Voir notre page cryptage et le logiciel rcrypto téléchargeable sur demande par mail; voir aussi la page cryptage en ligne du site. |

|

CYBERESPACE

Le terme cyberespace, introduit dans les années 1980 (par l'écrivain de science-fiction William Gibson dans un roman publié en 1984), est issu de l'anglais cyberspace, contraction de cybernétique et espace.

Il désigne l'ensemble virtuel des données numériques constituant toutes les informations et communications liées à l'interconnexion de tous les ordinateurs de la planète essentiellement par le réseau internet. Le cyberespace est à la fois outil géopolitique et acteur essentiel de la guerre mondiale des données , mais aussi responsable des cybermenaces, cyberespionnage, cybersabotages ... des hackers de toutes sortes. Et il a été dit qu'après la terre, la mer, le ciel et l'espace lointain, le cyberespace est le cinquième champ de bataille de l'humanité, dans lequel presque tous les humains passent (ou passeront) de plus en plus de temps en délaissant d'autant notre monde réel ...Mais quelle que soit l'évolution future, le cyberespace est devenu capital dans notre vie personnelle, professionnelle et sociale, mais aussi au niveau de tous les états. |

| DARWIN

Charles Darwin est né en 1809 et mort en 1882; il est le plus célèbre biologiste et naturaliste anglais, auteur de la théorie de

la descendance et de la sélection naturelle, plus connue sous le nom de théorie de l'évolution. Cet ouvrage (Sur l'origine des espèces) paru en 1859 a

révolutionné la théorie du vivant et a largement préparé la biologie moderne, même si à l'époque il lui a valu de nombreux reproches de ses contemporains. Cet ouvrage, épuisé dès le premier jour de sa parution, n'en a pas moins connu six rééditions corrigées différentes qui se succèderont jusqu'en 1872. Charles Darwin a parfaitement établi en particulier Trois principes de l'évolution : 1- Toute espèce animale présente des variations, des différences entre individus. 2- Certaines de ces particularités, affectant une population entière, semblent l'effet des conditions du milieu et ne sont pas transmissibles par hérédité ; d'autres n'affectent que quelques individus, mais elles sont héréditaires. 3- Du fait de leur fécondité, les espèces animales sont menacées en permanence de manquer de nourriture ; cette situation place les animaux en situation de concurrence vitale, d'où résulte la lutte pour la vie. Voir Darwinisme pour plus de précisions. L' influence de Darwin sur la pensée moderne est fondamentale tant dans la biologie de l'évolution que dans la philosophie de la science et du vivant. |

| PRINCIPE de DILBERT

C'est une version humoristique (et même fantaisiste) mais aggravée du principe de Peter ; son auteur est Scott Adams. Il exprime pourquoi les employés les plus incompétents deviennent toujours managers, les salariés les plus inefficaces étant toujours mutés aux postes d'encadrement, où ils risquent d'être le moins dangereux pour la société qui les emploie. Le livre de Scott Adams est un best-seller surtout aux Etats-Unis et il a dépassé les 140 millions de lecteurs. |

| DODECAPHONISME Le dodécaphonisme est un système musical basé sur les douze sons de la gamme chromatique utilisés dans n'importe quel ordre (et sans hiérarchie dans les notes) et non dans l'ordre tonal classique (do do# ré ré# mi fa ...), cette technique qui a engendré la compostion dodécaphonique a été imaginée par Arnold Schoenberg (1874 - 1951); elle donne une importance comparable à toutes les 12 notes de la gamme chromatique et évite ainsi toute notion de tonalité comme dans la compostion musicale tonale classique (celle depuis Jean-Sébastien Bach et son clavier bien tempéré jusqu'à Schoenberg ...). Voir les règles de l'harmonie classique avant le traité d'harmonie de Schoenberg en 1911. |

| EQUATION de DRAKE L'astronome Frank DRAKE est le fondateur, dans les années 60, du projet SETI (search for extra-terrestrial intelligence) qui se propose de détecter la présence de civilisations extraterrestres avancées, et l'auteur en 1961 de la célèbre équation (ou formule) de Drake. Celle-ci vise à estimer le nombre N probable de civilisations extraterrestres de notre galaxie capables de communiquer avec nous. Elle apparait sous la forme d'un produit de 7 facteurs mais il y a de nombreux et profonds désaccords sur les valeurs que peuvent prendre ces divers paramètres ...et suivant le cas diverses valeurs de N peuvent être fournies. Très spéculative, cette équation qui donnerait une fourchette 0 < N < 1.000.000 , au moins pour certains, est sujette naturellement à de nombreuses critiques, mais elle stimule les échanges sur le sujet de la vie intelligente extraterrestre. Elle est souvent mise en opposition avec le paradoxe de Fermi qui est plus pessimiste ... |

| DYSON (sphère de Dyson) Une sphère de Dyson est une énorme structure imaginée par le physicien Freeman Dyson (1923-2020) en 1960, constituée d'une immense sphère artificielle et creuse située autour d'une étoile (comme notre Soleil par exemple) et conçue pour en capturer et utiliser presque toute l'énergie émise. |

|

ECLIPTIQUE

L'écliptique est le grand cercle représentant la projection sur la sphère céleste

de la trajectoire annuelle APPARENTE du soleil autour de la terre. C'est encore l'intersection de la sphère céleste avec le plan

écliptique qui est le plan géométrique contenant l'orbite (réelle) de la Terre autour du soleil. L'écliptique et l'équateur céleste se coupent en deux points appelés noeuds, qui correspondent aux équinoxes (dans ces moments-là le jour et la nuit durent exactement 12 heures chacun): équinoxe de printemps, l'équinoxe de mars dans l'hémisphère nord et de septembre dans l'hémisphère sud, équinoxe d'automne, celui de septembre dans l'hémisphère nord et de mars dans l'hémisphère sud. |

| ECRAN TACTILE Il s'agit d'un périphérique informatique qui rassemble les fonctions d'affichage d'un écran et celles de pointage d'une souris. Il existe plusieurs types d'écrans tactiles. Les premiers, qui sont les plus simples et les plus économiques, sont de type résistif: il y a un empilement de trois couches dont deux sont conductrices et entre les deux une couche isolante: toucher l'écran revient à mettre en contact les deux films conducteurs et le courant peut passer. Dans la technologie à infrarouge, sont installés dans le cadre de l'écran plusieurs émetteurs qui produisent un maillage de rayons lumineux orthogonaux et l'impact d'un doigt ou d'un stylet vient interrompre le faisceau lumineux et les récepteurs vont alors détecter les coordonnées du point d'impact (pratiquement il suffit d'approcher le doigt à moins de 2 mm pour être détecté et ici le contact effectif n'est pas nécessaire). Dans les systèmes capacitifs, l'écran est recouvert d'une couche qui accumule des charges électriques; lorsque l'on touche cette couche avec son doigt, certaines charges nous sont transférées (le corps humain est conducteur d'électricité) ce qui crée un manque qui est détecté et mesuré par le capteur qui détermine ainsi les coordonnées de l'impact (attention dans ces cas on ne peut réaliser la manoeuvre avec des gants!). Cette technique est utilisée en particulier pour les GPS , certains PDA et pour les SMARTPHONES. Il y a aussi la technologie capacitive projetée, avec le même principe que le précédent mais sans avoir besoin de toucher l'écran pour créer le 'passage des charges'. D'autres technologies voient régulièrement le jour ... |

| EFFET DOMINO Effet Domino Physique Effet Domino Politique (ou théorie des dominos) Dans chaque cas, il s'agit d'une réaction en chaîne qui peut se produire lorsqu'un changement mineur peut se répercuter de manière similaire dans le voisinage immédiat et ainsi de suite, comme le font des dominos proches les uns des autres. |

|

EFFET CASIMIR

Prédit par le physicien H. Casimir (1909-2000) en 1948, il s'agit d'une force

attractive entre deux plaques parallèles conductrices non chargées; cet

effet est dû aux fluctuations quantiques du

vide qui sont présentes dans toute la théorie quantique des champs et décrites

dans la théorie de l'électrodynamique quantique. Cet effet est une conséquence bien réelle de l'énergie quantique du vide et,

d'une certaine manière est en relation avec un

calcul bien étrange de la somme des entiers (1+2+3+...) . Cet étrange calcul de cette somme (on sait que 1+2+3+..+n=n(n+1)/2 ) est dû à Ramanujan et se trouve dans l'un des ses célèbres cahiers . Dans le cadre de l'étude, toujours difficile, de la gravitation quantique, on a réuni la supraconductivité et l'effet Casimir . L' intérêt de l'effet Casimir est relancé, non seulement en liaison avec la toujours (un peu encore hypothétique) gravitation quantique mais aussi en cosmologie avec les trous noirs , les trous de vers et une éventuelle explication de la naissance de l'univers ... |

| EFFET DOPPLER L'effet Doppler (signalé par C. Doppler en 1842) est le décalage de fréquence d'un onde acoustique ou électromagnétique entre la mesure à l'émission et la mesure à la réception lorsque la distance entre l'émetteur et le récepteur varie au cours du temps; on réserve le nom d'effet Doppler- Fizeau dans les cas des ondes lumineuses (classique phénomène astronomique de décalage vers le rouge traduisant l'expansion de l'Univers ..). L'effet Doppler se manifeste par exemple pour les ondes sonores dans la perception de la hauteur du son d’un moteur de voiture, ou de la sirène d’un véhicule d’urgence. Voir l'effet Doppler relativiste. |

| EFFET HALL L'effet Hall classique découvert en 1879 par E. H. Hall, exprime qu'un courant électrique traversant un matériau baignant dans un champ magnétique (perpendiculaire au sens de passage du courant) engendre une tension (proportionnelle au champ magnétique et au courant) perpendiculaire à ceux-ci. |

| HIEROGLYPHE Les hiéroglyphes constituent un type d'écriture figurative utilisée par plusieurs anciens peuples, les égyptiens, les crêtois, les mayas, ... Des symboles ou des images remplacent les signes alphabétiques ou phonétiques des écritures plus récentes et plus traditionnelles. L'égyptologue français Jean-François Champollion fut le premier à déchiffrer les hiéroglyphes. L'écriture hiéroglyphique est apparue à la fin du IV ème millénaire avant notre ère en Haute-Egypte et a été utilisée jusqu'à l'époque romaine ...soit pendant plus de 3000 ans! Au nombre d'environ 700 dès l'époque archaïque, le nombre de hiéroglyphes n'a fait qu'augmenter au fil de l'histoire pharaonique, d'où la nécessité d'une classification des hiéroglyphes pour les caractériser de manière univoque. |

| EFFET

MAGNUS

L'effet Magnus, découvert par Heinrich Gustav Magnus (1802-1870), physicien allemand, est un principe physique qui explique la force tangentielle subie par un objet en rotation se déplaçant dans un fluide. C'est cette force qui explique la modification de trajectoire qui prend alors une forme incurvée;

il permet notamment d'étudier et de prévoir les effets de balle dans divers sports, comme en particulier le tennis et le football, mais aussi le ping-pong, le rugby, le golf ... Quand la vitesse d'un fluide (comme l'air) augmente, sa pression diminue, et réciproquement, comme l'indique l’ équation de Bernoulli . Lorsqu'une balle en rotation se déplace dans l'air, elle va par frottement modifier la vitesse du courant d'air autour d'elle. L'effet sera dissymétrique: d'un côté la balle entraîne l'air qui accélère. De ce côté la pression diminue. De l'autre côté la balle freine l'écoulement d'air et la pression augmente. On aura donc une différence de pression et la balle va se déplacer du côté où la pression est plus faible. Selon la vitesse de rotation de la balle, la position des points où la vitesse est respectivement minimale et maximale (et donc le sens de la force appliquée) varie. Pour être complet il faut préciser que c'est la turbulence et l'effet Magnus qui interviennent dans les diverses trajectoires d'objets en rotation ... |

| EFFET PAPILLON L' effet papillon est explicité dans le fichier Systèmes Dynamiques et Chaos . |

| EFFET TUNNEL L'effet tunnel est un phénomène très fréquent en mécanique quantique. Il intervient par exemple dans la production d'énergie des étoiles ou encore il est responsable de la radioactivité alpha; il a été découvert par Georges Gamow en 1928. C'est la propriété que possède un objet quantique de franchir une barrière de potentiel même si son énergie est inférieure à l'énergie minimale requise, franchissement impossible dans le cadre 'macroscopique' de la mécanique classique (où une particule ne peut pas franchir un obstacle si cela lui demande plus d'énergie que celle dont elle dispose); dans le cadre quantique les particules ont un comportement 'probabiliste' et il y a toujours une 'faible probabilité non nulle' pour qu'elle 'traverse' l'obstacle. En 1981, grâce à cette propriété, on a mis au point le microscope à effet tunnel qui permet de cartographier atome par atome la surface d'un matériau conducteur. Voir quelques précisions sur l'importance de l'effet tunnel en physique. On parle aussi d'effet tunnel en management de projet ... |

| ENERGIE L'énergie est, en physique, la capacité d'un corps ou d'un système à produire un travail (qui est une variation), entraînant un mouvement ou produisant de la lumière ou de l'électricité (plus généralement une onde électromagnétique), de la chaleur, un son, une onde gravitationnelle ...Toute masse m, isolée et au repos dans un certain référentiel, possède (du fait de cette masse) une 'énergie de masse' (colossale) exprimée par la célèbre formule d'Einstein E = mc², où c est la vitesse de la lumière. D'après le premier principe de la thermodynamique, l'énergie d'un système isolé est conservée au cours de toute transformation (on dira plus simplement que l'énergie ne peut ni être crée ni disparaitre, c'est la classique 'loi de la conservation de l'énergie'); elle s'exprime en joules, en kWh ou en eV (électron-volt). On peut effectuer des transferts d'énergie (par exemple l'énergie thermique d'un feu de cheminée se transmet dans l'air du voisinage et vient nous chauffer, c'est le transfert de chaleur) et des transformations d'énergie, qui expriment, contrairement au cas précédent, le passage d'une forme d'énergie à une autre, par exemple l'énergie électrique d'une ampoule transformée en énergie lumineuse rayonnante ou l'énergie cinétique d'un corps en mouvement transformée en énergie potentielle. Les formes essentielles d'énergie sont: énergie mécanique (cinétique et potentielle), thermique, chimique, nucléaire, rayonnante ... et elles peuvent toutes se convertir en toute autre forme. |

| ENERGIE NOIRE (ou énergie sombre) L'énergie noire (encore quelquefois considérée comme l'énergie du vide quantique ...) est une forme (hypothétique) d'énergie inconnue en laboratoire, emplissant tout l'univers; dotée d'une pression négative ce qui la fait se comporter comme une force gravitationnelle répulsive, cette énergie noire, ou sombre, est mise indirectement en évidence par diverses observations astrophysiques, notamment par l'acccélération de l'expansion de l'univers (observations et mesures de supernovae lontaines et du rayonnement fossile micro-onde dans les années 1990). Elle représenterait de l'ordre de 70 % de la densité totale d'énergie de l'univers et elle pourrait parfaitement expliquer cette accélération de l'expansion. Cette (encore mystérieuse) énergie noire se comporte comme la constante cosmologique introduite par Einstein dans ses équations, puis retirée (il parlait de la plus grande erreur de sa vie ...) et réhabilitée avec la mise en évidence de l'accélération de l'expansion de l'univers. Voir un relevé cartographique récent pour étudier l'énergie noire. Bien que la théorie du Big Bang et la relativité générale d'Einstein expliquent assez bien le passé de l'univers, il reste de nombreuses énigmes à élucider pour que la théorie colle parfaitement avec les diverses observations cosmologiques; c'est pour cela que les chercheurs ont recours à des concepts hypothétiques comme l'énergie noire, ou comme (ne pas confondre ...) la matière noire . |

| ENTROPIE L'entropie caractérise le degré de désorganisation - ou désordre- (dans le cadre de la thermodynamique) ou le manque d'information d'un système (dans le cadre de la théorie de l'information de Shannon). Pour les physiciens, l'entropie mesure l'incertitude sur l'état d'un système physique, pour le théoricien de l'information, elle mesure l'incertitude sur un message, parmi tous les messages possibles qu'une source de communication peut produire. Le terme entropie a été introduit en 1865 par Rudolf Claudius (1822-1888) en particulier dans le cadre du deuxième principe de la thermodynamique qui exprime que l'entropie de tout système isolé ne peut pas diminuer. L'entropie de l'univers ne peut pas diminuer au cours de son évolution, ou encore l'univers évolue spontanément au cours du temps vers un plus grand désordre. Statistiquement tout système tend vers un état à entropie maximum, les états désordonnés étant plus probables que les états ordonnés. |

| EXCITON .

En physique de la matière condensée, un exciton est une quasi-particule constituée d'une paire électron-trou; il s'agit d'une

zone où un électron est manquant, et qui se compote donc comme une particule de charge positive. On peut encore décrire un exciton comme une onde de polarisation neutre dans un matériau. Un exciton est un polariton particulier. Par exemple dans un semi-conducteur, l' excitation quantique par absorption d'un photon correspond à la formation d'un système lié (par la loi de Coulomb) électron-trou. On distingue en général deux sortes d'excitons, l' exciton de Mott-Wannier et celui de Frenkel . |

| EXOPLANETE Une exoplanète, ou planète extrasolaire, est une planète en orbite autour d'une étoile autre que notre Soleil. Voir notre page exoplanètes (au 31/01/2012 on avait répertorié 755 exoplanètes). |

| FERMAT

Pierre Simon de Fermat (1601 - 1665) est un grand mathématicien

français du XVII ° siècle, né à Beaumont-de-Lomagne et mort à Castres; sa célèbre conjecture

énoncée en 1637 n'a été démontrée que 357 ans plus tard en

1994 pour devenir le Théorème

de Fermat-Wiles . Ses nombreux travaux ont fait grandement

progresser le calcul différentiel et intégral, les probabilités, la

géométrie analytique, la théorie des nombres (avec en particulier le Petit théorème de Fermat et

le théorème des deux carrés ),

mais aussi l'optique avec le principe de Fermat

... Le théorème de Fermat-Wiles. Pour x, y, z, n entiers non nuls et n supérieur ou égal à deux, on considère l'équation: 1637 Théorème de Fermat Théorème. Dès que n > 2, cette équation n'a pas de solution avec des entiers x, y, z non nuls . Entre 1955 et 1960, la conjecture de Shimura-Taniyama-Weil est formulée. En 1986, Ken Ribert démontre que la conjecture STW implique le théorème de Fermat . En 1994, Andrew Wiles démontre la partie essentielle de la conjecture STW qui entraîne, conformément au théorème de Ribert, la validité du théorème de Fermat. Cette partie de la conjecture concerne certaines équations, définissant des courbes elliptiques, de la forme En 1954, Martin Eichler a pu construire une fonction génératrice (forme modulaire) qui fournit toute l'information sur le nombre de solutions de cette équation modulo tous les premiers p. La conjecture affirme que toutes les équations cubiques peuvent se traiter de cette manière. En 1999, le cas général de la conjecture STW a été démontré. Dans cette longue démarche en théorie des nombres, il faut citer le programme de Langlands , formulé dans les années 1960 par le grand mathématicien britannique Robert Langlands , et les conjectures locales de Langlands . Théorème des deux carrés. On l'appelle encore le théorème de Fermat de Noël car Fermat l'a envoyé à Mersenne le 25 décembre 1640 dans une longue lettre. Un nombre premier p strictement supérieur à 2 est somme de deux carrés d'entiers si et seulement si p est congru à 1 modulo 4. L'année 2017 (=4x504+1) possède cette propriété avec 2017 = 442 + 92 et ce phénomène ne se reproduira pas avant 2029 qui vérifie 2029 = 452 + 22. On peut aussi citer le théorème des 4 carrés de Lagrange (1770) qui exprime que tout entier positif s'écrit comme la somme de 4 carrés ou moins; on a pour 2017 = 442 + 42 + 42 + 72, ainsi que le théorème des 3 carrés de Gauss (1801) qui exprime qu'un entier s'écrit comme la somme de 3 carrés si et seulement s'il n'est pas de la forme 4a (8k -1), a et k entiers positifs. L'année 2017 s'écrit aussi 332 + 282 + 122. Rappelons enfin l' identité des 4 carrés d'Euler (1748) qui établit que le produit de deux nombres, chacun étant la somme de 4 carrés, est lui-même une somme de 4 carrés; cette propriété peut être considérée comme la généralisation d'un vieux résultat de Brahmagupta (598-668) qui exprime que le produit de deux nombres, chacun étant la somme de deux carrés, est lui-même la somme de deux carrés. |

| PARADOXE de FERMI

Le physicien Enrico FERMI (1901-1954), prix Nobel de physique en 1938 fut un grand spécialiste de physique nucléaire avec en particulier la mise en évidence de nouveaux éléments radio-actifs. Il développa aussi les débuts de la statistique quantique qui deviendra la statistique de Fermi-Dirac . C'est dans les années 50 qu'il exprima les célèbres questions: 'Sommes-nous la seule civilisation intelligente dans l'univers ? et si non pourquoi les extraterrestres ne sont-ils pas déjà chez nous ? Où sont-ils donc ?' Paradoxe pour les uns, dilemne ou problème de logique pour les autres, anthropocentrisme pour quelques autres ...mais toujours pas de consensus sur la solution du problème. Si l'on postule l'existence d'une vie extraterrestre, pourquoi celle-ci ne s'est-elle jamais manifestée ? ...Dans les années 60 l' équation de Drake sera proposée pour tenter de déterminer une estimation du nombre probable de civilisations extraterrestres ...et formuler une appréciation plus optimiste que le paradoxe de Fermi . |

| FIBONACCI

Pisano Leonardo dit Fibonacci Leonardo (1175-1245) est un mathématicien italien qui a écrit divers ouvrages de géométrie et d'arithmétique, en particulier le fameux 'liber abaci', le livre de l'abaque. De ses séjours et voyages en Algérie, Egypte, Syrie il rapporta à Pise (où il a vécu à l'époque de la construction de la célèbre tour penchée) les chiffres arabes, le système d'écriture décimale et la notation algébrique; c'est depuis

que, pratiquement partout dans le monde, on a délaissé les chiffres romains au profit des chiffres indo-arabes. Dans son liber abaci, il propose en 1202 un 'problème récréatif' décrivant la croissance d'un couple de lapins enfermé de tous côtés dans un enclos isolé; c'est en fait le premier modèle mathématique en dynamique des populations (et peut-être l'ancêtre des systèmes itératifs non linéaires des débuts de la théorie du chaos du XX ème siècle...). Sachant que tout couple de lapins, dès le début du troisième mois de son existence, engendre tous les mois un nouveau couple, combien y aura-t-il de lapins dans l'enclos au bout d'un an ? (en supposant que les lapins ne meurent pas). Au début du premier mois il y a une paire de lapins, au début du second, toujours une paire, au début du troisième il y en a deux, puis trois, puis ... et on construit donc facilement une suite de la forme (on peut la faire débuter par 0) 0, 1, 1, 2, 3, 5, 8, 13, 21, 34, 55, ...la célèbre suite de Fibonacci (voir la suite en ligne ). Chaque terme de cette suite est la somme des deux termes précédents et elle peut être définie par la récurrence: Ajoutons enfin que diverses extensions des suites de Fibonacci ont été développées comme par exemple, les suites de Lucas , les nombres de Pell ou les suites de Tribonacci (dont l'équation caractéristique est x3-x2-x-1=0); même l'analyse technique des cours boursiers fait intervenir la méthode des 'retracements de Fibonacci' pour déterminer des objectifs de cours dans les phases de consolidation. |

| FIBRE OPTIQUE De nos jours, la fibre optique (fil de verre ou de plastique très fin, conducteur de la lumière) est un media utilisé pour transmettre toutes les données numériques comme les paquets Ethernet mais aussi les sons et les videos (voir comment fabriquer, connecter et mesurer la fibre optique). |